自作したロボットアームを制御する(現実認識を行う)(その3)音波で距離を認識する

OpenCVとVisual studio C++を使って、形状や文字を認識できる様になったので、物体までの距離を測定し、実際の大きさやロボットアームの位置補正などが行える様にする為に、距離センサのHC-SR04を使用し距離を測定してみた

距離センサのHC-SR04の制御はとても簡単で、電源に5V掛けて、トリガー端子に10μSecの信号を入れるとエコー端子に、距離に応じたパルスが入ってくるお手軽簡単モジュールとなっている

んで、アマゾンさまで、3個セットで799円で売っていた物を購入して、モジュール基板のシルク印刷通りに配線を行い、ロジックアナライザで測定した結果、以下の様になった

[結果結果]

[測定写真]

結果としては、まずまずなのだが、ネットで公開されているものよりは、良くないような…?

測定環境により、多少の誤差はある様な感じってところですかね

とりあえず、ミリ単位の測定は難しそうだけど、全体的な測定を行う事は出来そうなので、人感センサーの代わりに使用したり、ざっくりなエコーロケーションとかにも良いかもですね

しかし、ロボットアームのキャリブレーション様には難しそうなので、他を探す事しよう

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

PICを使用して開発する事にした(32BitMCUのPIC32MX系を使用する)

ロボットアームに取り付けるカメラ制御が出来たので、距離センサなどの制御を行う事にしよう思い、久しぶりにPICでの開発を再始動しようとしたが、MPLAB Xが、インストールされていない!

そうだ!、Windows8から、Windows10にアップデートする時に、パソコンを初期化したので、PICの開発環境をきれいさっぱりと消してしまった事を思い出した

と言うことで、PICの開発環境(MPLAB X)をインストールする事にした

「PICを使用して開発する事にした&三日坊主にならずに済んだ!」を参考に以下をインストール

MPLABX-v3.45-windows-installer.exe

xc8-v1.38-full-install-windows-installer.exe

xc16-v1.26-full-install-windows-installer.exe

xc32-v1.42-full-install-windows-installer.exe

(2016年11月8日時点)

んで、インストールした後に、Code Configurator(MCC)をPluginしたら、ずいぶん画面が変わっている

確認したら、バージョンが、「v2.25.2」から「v3.25」と、ずいぶんバージョンアップしている

少し困ったのが、「v2.25.2」で作成したプログラムを「v3.25」で修正する事が出来ない

これでは、過去に作成したプログラムをメンテナンス出来ないので、以下の手順で複数のバージョン切り替えが出来るようにしてみた

1)コードコンフィグレータのnbm(NetBeansモジュール)をダウンロードする

http://www.microchip.com/mplab/mplab-code-configuratorのアーカイブから、

com-microchip-mplab-modules-mcc-2.25.2.nbmをダウンロードし、適当な場所に解凍しておく

2)MPLAB Xにインストールする

MPLAB Xを起動する

[Tools]メニューから[Plugins]を選択すると画面が開くので、

[Download]タグを選択し、[AddPlugins]を押し、nbmファイルを指定し、

説明に従いインストールを行う

3)バージョンを選択する

MPLAB Xを再起動し、[Tools]メニューから[Embedded]を選択する

[MPLAB Code Configurator]が追加されているので、これを選択する

以上で、過去に作成したプログラムをメンテナンス出来る様になった

また、今回のCode Configurator(MCC)を確認していたら、32Bit系のPIC32MXも使用できる事に気付いた

[pic32mx_v1.00.ja]ファイルを確認すると、PIC32MX系とPIC32MZ系までが使用可能なので、一番容量が大きくて使い易そうな、PIC32MX170F256Bを使用し、色々と開発する事にしてみた

(本当は、PIC32MZ系を使用してみたいけど、軍事転用可能で国外取引には審査が必要なので後日検討する事にしました)

PIC32MX170F256Bは、PIC24FJ64GA002と比べて、とてもコストパフォーマンスが良い!

[Output Compare]は、内蔵されていないみたいだけど、速度も容量も何倍に増えて、お値段は500円以下と、とても、とてもお買い得な物になっているし、何よりプログラム容量が256Kbyteはありがたい

が!、マニュアルが英語版しか見つからない!

英語と数学を避けて、図画工作系の技術者になった筆者には、少し辛いが見つからない物は仕方ない

以下のサイトより、リファレンスマニュアルをダウンロードして調べる事にしたが、マニュアルのページ数は、2つ合わせて1500ページ近くもあるので、気合と根性が試される事になった

しかし、このページ数は病人じゃなくても病人になりそうだ(あくまでも、個人の感想ですよ)

http://www.tme.eu/en/Document/5d4fa517ccd831b6a5c79ea5c7266851/pic32mx1xx_2xx.pdf

http://hades.mech.northwestern.edu/images/2/21/61132B_PIC32ReferenceManual.pdf

んで、マニュアルを読んだ(気合も根性が足りずに斜め読みになってしまった…です)結果、PIC24FJ64GA002と同じ接続方法で良い事が判明(I2Cを除く)したので、PICkit3を使って、動作確認を行う事にしてみた

接続などは、「PICを使用して開発する事にした&三日坊主にならずに済んだ!」を参照する

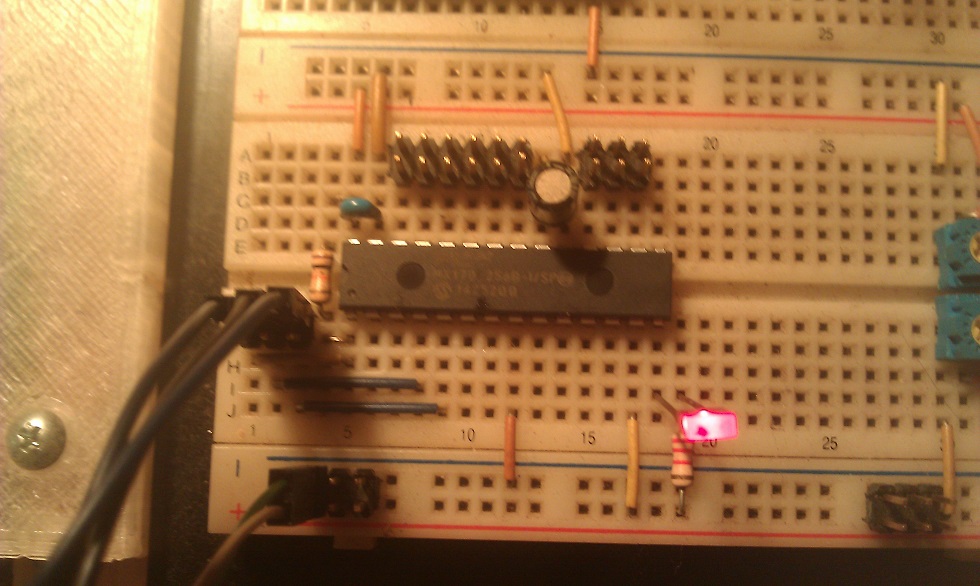

〔PICkit3とPIC32MX170F256Bの接続写真〕

〔プログラム作成〕

1)MPLAB Xを起動し、スタートガイドに従いプロジェクトを作成する

Select Deviceで、[32-bit MCUs (PIC32)]、[PIC32MX170F256B]を設定する

Select Toolで、[PICkit3]を選択する

Select Compilerで、[XC32]を選択する

2)MPLAB XのCode Configuratorを使用して必要機能とピン割り当てを設定する

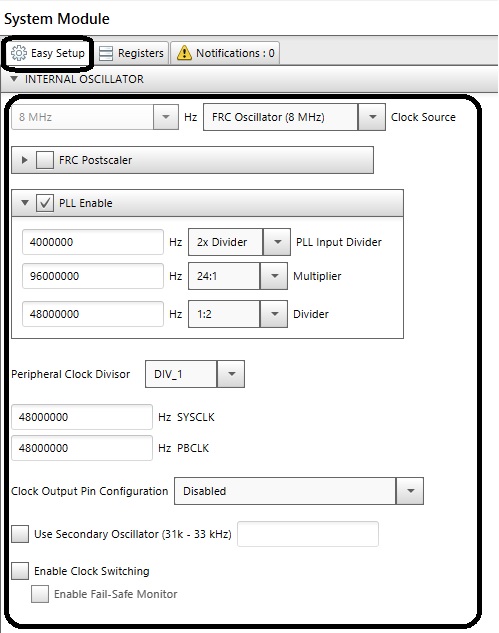

a)Systemを設定する

図ー1を参照して下さい

今回は、48MHzで設定してみました

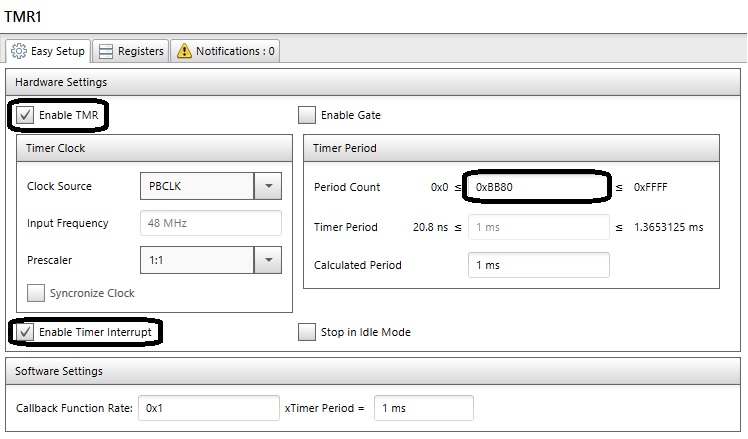

b)TMR1を追加しタイマ間隔を設定する

図ー2を参照して下さい

今回は、1mSecで設定してみました

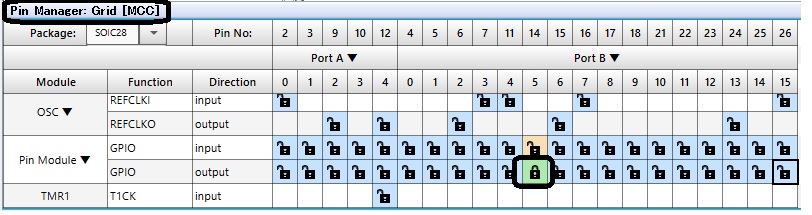

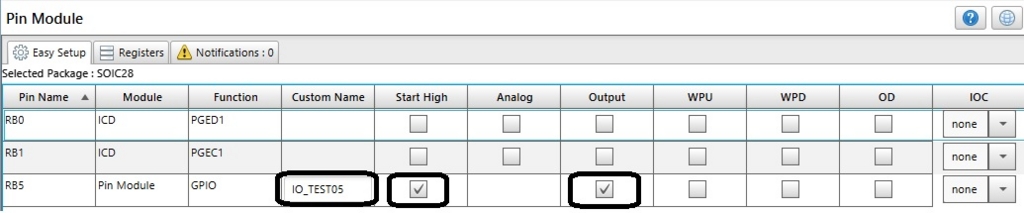

c)Pin Managerで、入出力ピンの設定を行う

図ー3、図ー4を参照して下さい

今回は、RB5を出力に設定し、名称を[IO_TEST05]にしてみました

3)[Generate Code]ボタンを押してコード生成を行う

4)LEDをチカチカさせる為のコードを記述する

と、言っても、MPLAB XのMCC(Code Configurator)がプログラムの

大半を自動生成してくれるので、コーディングは以下の数行となる

int main(void)

{

uint8_t uiTimer;

uint16_t uiCount;

// initialize the device

SYSTEM_Initialize();

IO_TEST05_SetHigh();

while (1)

{

// Add your application code

if ( TMR1_SoftwareCounterGet() != uiTimer ) {

// 1mSec毎に変化する

uiTimer = TMR1_SoftwareCounterGet();

uiCount++;

// 1秒経過したか確認する

if ( uiCount >= 1000 ) {

// 出力を反転させる

IO_TEST05_Toggle();

uiCount = 0;

}

}

}

return -1;

}

5)コンパイルする

6)書き込みを行う

7)LEDがチカチカすれば回路に問題無し

〔図ー1〕

〔図ー2〕

〔図ー3〕

〔図ー4〕

しかし、PIC32MXでMCC(Code Configurator)を使用している人はいないようです

やはり、このスペックなので、FreeRTOSのHarmonyを使用しているみたいですね

筆者も、Harmonyを使った方が良いのかなぁ~って悩んでます

ちなみに、8ビットMCUと16ビットMCUは、以下を参照してください

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

自作したロボットアームを制御する(現実認識を行う)(その2)OpenCVで将棋の駒を認識する

OpenCVとVisual studio C++を使ってオセロのコマが認識できる様になったので、プログラムに認識方法などの改良をして将棋の駒が認識できるかやってみた

駒の重なりや光源などの影響で誤認識を起こしたり、認識スピードが遅いなど色々と解決しなければいけない問題点はあるが、とりあえずのところ何とかなりそうだ

後は、OpenCVの学習機能などを利用して、認識率と処理速度を向上させるとしよう

それにしても、凄い時代になったものだと、つくづく感じでしまう

以前、音声合成を作成した時の費用が、1000円程度で、今回の画像認識用のWebカメラも1000円程度!

今は、ノートパソコンを使用しているけど、RasberryPIなどのボードコンピュータにプログラムを移植すると、電源回りを含めても1万円ぐらいで出来てしまう

ずいぶん前に、ガレージメーカーと言うのが有ったけど、開発環境も含めて、アイデアさえ有れば、わずかな金額で起業する事が出来そうだし、CADが使えれば、機械が作ってくれるので、人手もいらない

これで人工知能が、どんどん進化すると、10年後に、良いアイデアを出す人以外はどうなるのか、普通の開発案件は有るのか、少し不安になってしまう今日この頃です

[認識結果]

[認識している動画]

さて、将棋の駒が認識出来るようになったので、エドと将棋が打てるようになる

ん! えっ! うぁ~! 将棋のプログラムを考えて無かったです

オセロなら何とかなりそうなので、エドとはオセロで遊ぶ事にしよう

そうだ!そうしよう! 将棋は、しばらく封印する事にしようと、筆者は涙ながらに思うのであった

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

自作したロボットアームを制御する(現実認識を行う)(その1)OpenCVでAR(拡張現実)を行う

自作したロボットアームのエドをVR(仮想現実)上で自由に動かせたので、エドの目を作成する事にした

こちらも、OpenGLと同様に、OpenCVとVisual studio C++を使って作成する事にした

OpenCVを使用してのプログラムは、参考にするサイトが色々とあり、OpenGLに比べて、楽に組めた

ただ、OpenCVのバージョン毎のコーディングが違っていて、整理するのに苦労してしまった

んで。手始めに少し前に流行ったAR(拡張現実)を使って、オセロのコマを認識する事にしてみた

注意点は、使用したリソースをプログラム終了時に開放しないと、プログラムが正しく終了しない

また、使用するWebカメラによって、初回取り込みまで一定の時間(1秒程度)経過して取り込まないと正しく取り込めない

[処理手順]

1)オセロのコマの画像を白と黒、それぞれで用意する

2)OpenCVを使って、画像を取り込む

cvCaptureFromCAMでカメラと接続する

cvQueryFrameで画像をキャプチャーする

3)コマ(白、黒)のマッチングを行う

matchTemplateを使用して、画像が含まれているか確認する

戻り値の認識率が一定の値以上なら、含まれているので、

認識した位置を使用して、表示を行う

[認識結果]

[認識している動画]

余談だけど、ドラマ24の「勇者ヨシヒコ」を見ていて思ってしまった事が、このまま、エドにカメラを取り付け、文字が読める様になり、自分で学習出来るようになると、「寄生獣のミギー」、いや「ヒダリー?」みたくなってしまう...

ん~、何かの啓示なのか、これを機会に改名しろと神様が言っている...はずは無いか!

やはり真面目に取り組む為にも、エドで行こう!

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

自作したロボットアームを制御する(仮想現実での制御)(その4)計算により関節の角度を求める

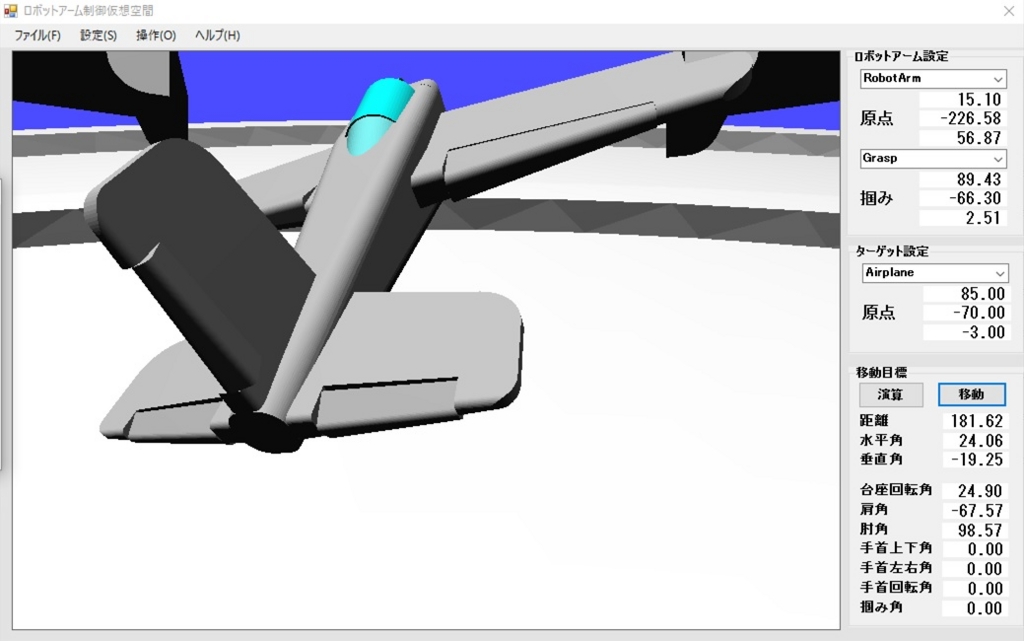

自作したロボットアームのエド(2016年06月13日)のCadデータをVisualStudioとOpenGLを使用してVR(仮想現実)で自由に動かせる様になったので、目標位置に対して、各関節の角度を演算により求める事が出来るようにして、目標角度までをアニメーション表示出来るようにもしてみました

ついでに、移動目標が〇だと寂しいので、移動目標を飛行機(本当はヘリコプターにしたかったけど、難しかったので断念しました)にして、ロボットアームvs飛行機って感じのCGが、以下になります

[エド vs 飛行機]

計算手順は、意外と簡単で、以下のように計算してみました

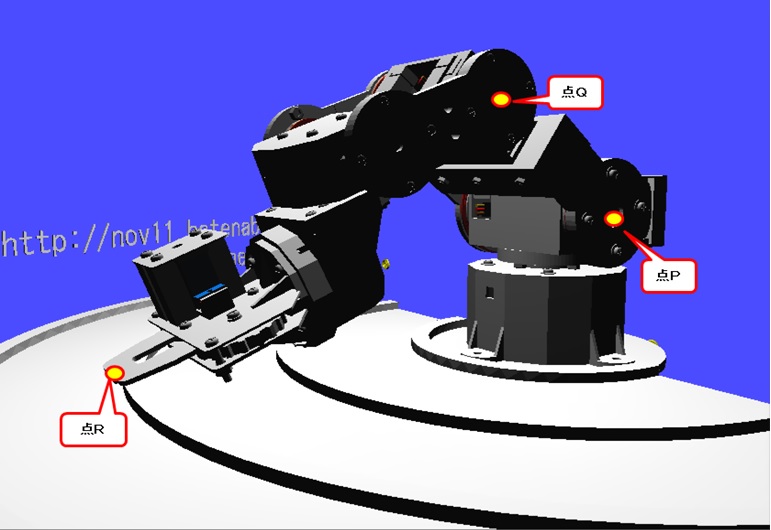

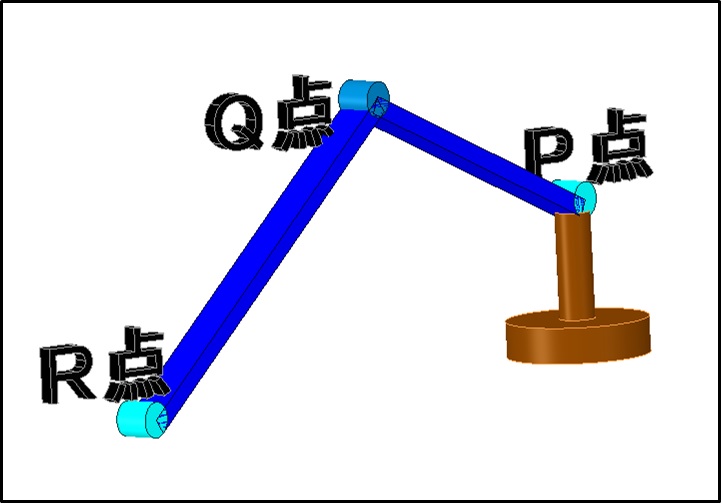

ロボットアームの基準座標を点P,飛行機の座標を点R,ロボットアームの関節座標を点Qとします

図で表すと、図ー1の様になり、簡略化した物が図ー2となってます

(注意)筆者は、図画工作系の人間なので、数学的表現が微妙となってます

[計算手順]

1)ロボットアームの基準座標と飛行機の座標との水平垂直角度を求める

空間座標が分かっているので、atan(アークタンジェント)により求める

2)ロボットアームの基準座標と飛行機の座標との直線距離を求める

「ピタゴラスの定理」で求める

3)点Rの座標を求めて、角度を算出する

2)で求めた長さと1)で求めた垂直角度から、点Rの座標を求める

肩から肘(P-Q)の長さ(A)と、肘から掴み(Q-R)の長さ(B)はわかっているので、

点Pを中心に半径Aの円と点Rを中心に半径Bの円の交点を求めて、点Qとする

後は、点P、Q、Rの角度を求めれば、計算完了となる

言葉ではわかりずらいので、図ー3を参照してください

[図ー1]

[図ー2]

[図ー3]

んで、計算し動作させると、こんな感じです

youtu.be

やっと、VR(仮想現実)とは言え、任意の空間座標にアームを動かせる様になったので、いよいよ画像認識に取り掛かろうと思うけど、複数の空間座標を通るようにしてからにするか迷うところです

迷う理由は、複数の空間座標を通す為に、3次元の補間計算プログラムを作成しないといけない...

結構大変な作業になりそうなので、悩ましぃとことです

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

自作したロボットアームを制御する(仮想現実での制御)(その3)カメラを取り付ける

エド(仮想現実)の手にカメラを取り付けて、エドの主観で仮想空間を見れる様にしてみた

また、エドの指先の空間座標を表示できる様にもして見た

実は、今回の苦労してVR(仮想現実)を作成した目的は、この2つを行いたかったからだ

複数の関節を動かした際に、ロボットアームの指先が、基準点(台座の中心点)から、どれくらいの距離なのかを算出したかったのと、仮想現実で表示内容とWebカメラで撮影した映像をOpenCVで画像処理した物を比較する事によりエドの動作状況をフィードバックさせる事が出来るようにする為だった

また、エドの主観視が出来たことで、抽象的な表現(上下左右など)をエドが認識できる

つまりは、「エドから見て、右上の赤いボールを、左の台に移動させて」が通じる様になるのだ

(右は、第一象限、左は第二象限、上は高さと言う感じです)

後は、音声認識ソフトを使用して、音声によりエドに指示が出せると言う、SF映画などでよく見る光景を作り出す事が出来そうです!

今回のプログラムは、OpenGLとEigenを使用しているので、スマートフォンにも移植しやすいので、スマートフォンの音声認識機能を使用すれば、スマートフォン+インカムで、やり取りさせる事が出来る

おぉ~!、まさにSF映画だぁ~!!

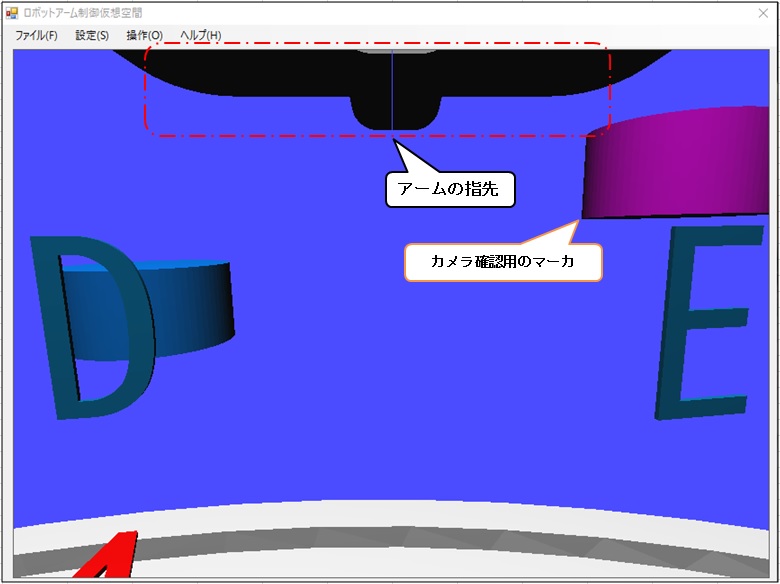

[ロボットアームの画面]

(アームの先端にカメラと画面右上に空間座標が表示されてます)

[ロボットアームのカメラ動作確認用マーカ]

(テーブル上にアルファベットと高さ確認用のマーカを表示しています)

[ロボットアームのカメラに切り替え]

(テーブル上のアルファベットと高さ確認用のマーカが表示されています)

んで、エドの主観視した動画を撮ってみました(右上の数値が指先座標です/単位はミリ)

ロボットアームにカメラを取り付け仮想空間を撮影してみた

youtu.b(カクカク動いてますが、操作に慣れていない為です)

この動画でテーブル全面を収める事が出来たので、カメラの取り付け位置は問題ないようです

後は、目的解釈部分と画像認識、音声認識を作成すればVR(仮想現実)シミュレーション完成となる

ここまでで1ヶ月以上掛かった事を考えると、先は長そうだけど、体壊さないように頑張らねばです

今回の主観視を作成していて気付いたのだが、ここまでのプログラムでドックファイトやカーチェイスなどのゲームが作成できるのだ!

体は、少し不自由になったけど、VR(仮想現実)ならそんな制約は無いので、色々と妄想してみよう

最後に、VisualStudioC++とOpenGLの制御手順をまとめてみました

[OpenGLの制御手順]

1)OpenGLのダウンロードする

ここは、「OpenGL ダウンロード」でググると出てくるので、

サイトの記述に従いダウンロードする

Windowsで、「OpenGL32.lib」を使用する場合には、1~3は不要で、

インクルードを以下のように記述する

----------------------------------------------

#include <windows.h>

#include <GL/glu.h>

#include "OpenGL.h"

#pragma comment (lib, "OpenGL32.lib")

#pragma comment (lib, "GLU32.lib")

#pragma comment (lib, "user32.lib")

#pragma comment(lib, "gdi32.lib")

----------------------------------------------

2)Windowsフォームアプリケーションを作成する

VisualStudioの新しいプロジェクトで、VisualStudio C++の

Windowsフォームアプリケーションを作成する

VisualStudioは、2010以前を使用すると作成し易くなる

3)OpenGLを配置する

ヘッダー、ライブラリー、DLLファイルを新規作成した

フォルダーに配置する

4)OpenGLの設定を行う

Form1.hのコンストラクタで、描画するコントロールの

デバイスコンテキストを取得し、OpenGLの初期設定を行う

wglDeleteContext,ReleaseDCなどを設定する

5)Cadデータを読込む

DesignSpark mechanicalで、OBJファイルを出力しておく

OBJファイル構成は、ネットに沢山あるので、そちらを参照する

6)カメラ設定を行う

a)視野を設定

glMatrixMode( GL_PROJECTION );←ここが無いと変更出来ない

glLoadIdentity();

gluPerspective();←引数は、Eigenを使用して求める

b)カメラの位置、姿勢の設定

glMatrixMode( GL_MODELVIEW );←ここが無いと変更出来ない

glLoadIdentity();

gluLookAt();←引数は、Eigenを使用して求める

c)バッファのクリア

glClear();←引数は、ググると出てくる

d)ライトの設定

glEnable();←引数は、ググると出てくる

glLightfv();←引数は、ググると出てくる

7)パーツ表示を行う

パーツ単位をglPushMatrixとglPopMatrixで挟み込み以下を繰り返す

a)パーツの移動位置と回転をglTranslatedとglRotatefで指定する

b)パーツのマテリアルをglMaterialfvで指定する

c)パーツを構成するポリゴンをglVertex3fvで指定する

各パーツは、glBeginとglEndで挟み込む

8)全て設定した後に、SwapBuffersを行う

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい

自作したロボットアームを制御する(仮想現実での制御)(その2)パーツを連動させる

エドの制御を行うために、エドの駆動9パーツを仮想空間に配置し、連動できる様にしてみた

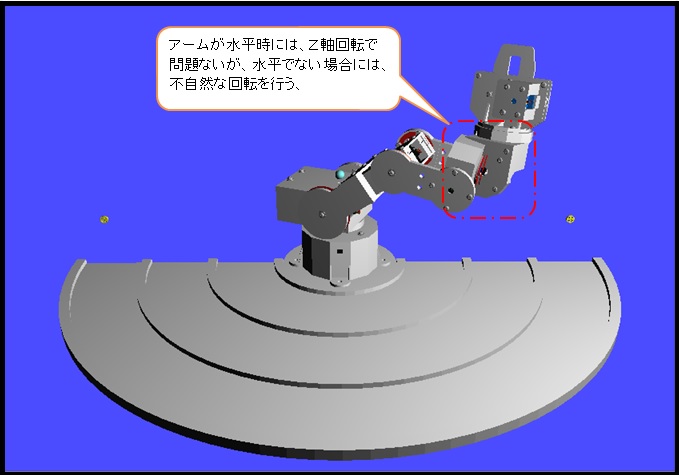

が!、下図の様になってしまい想像通りには、全くさっぱりイメージ通りに表示してくれない!

[失敗イメージ]

(手首部分が正しく回転していない)

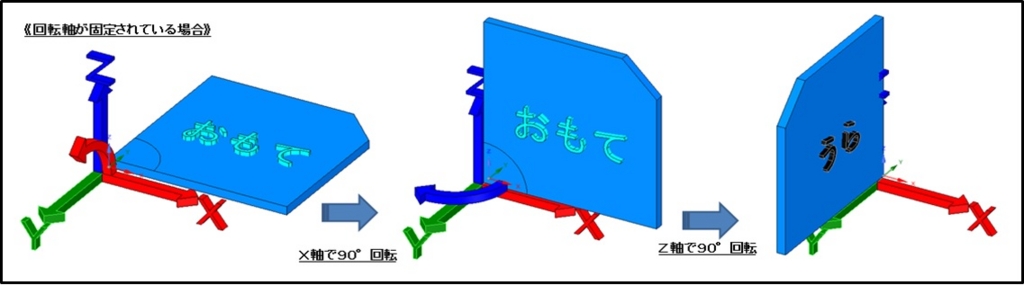

イメージ通りにいかない原因を調査した結果、OpenGLが予想と違う動きをしている事が分かった

予想と違っていたのは、OpenGLの回転指示関数(glRotatef)でモデルを回転させると、回転軸も追従して回転してくれていると思い込んでいたのだが、回転軸が追従してくれないので下図のように不思議な結果となってしまった

[予想していた回転]

(クリックすると拡大表示されます)

[現実の回転結果]

(クリックすると拡大表示されます)

んで、この問題を解決する方法をググったら「Quaternion:クォータニオン(四元数)」って単語が出てきたので、クォータニオンが記載されているページを開いた瞬間、ブラウザを閉じてしまった

思わず閉じてしまったホームページには、数式と文字が羅列され、図画工作系の筆者には、あまりにも敷居が高く、その領域に踏み込む事を危険と判断して、勝手にブラウザを閉じてしまったようだ

しかし、ここで諦めるわけにはいけないので、ブラウザを起動し、クォータニオン(四元数)を改めて、ググり恐るおそるクリックすると、やはり数式と文字が羅列されていて、取り付く島もない

何とか、図画工作系の筆者にも分かる様なサイトを見つけて、読み進むが、あっ!と言う間に頭の中を「?」マークが埋め尽くしてしまう…

んで、「ページを開く→「?」マークが頭を埋め尽くす→ブラウザを閉じる→落ち着く」を繰り返すこと3日!何とか取り付く島が出来たので、改めて纏めてみた

結果、OpenGLには、クォータニオンは含まれていないので、OpenGLの回転指示関数(glRotatef)に渡す回転軸を、クォータニオンで求める必要がある事が分かったので、クォータニオンをしてくれる行列演算ライブラリ(Eigen)を使用してプログラムを作成することにした

幸いC++でプログラムを作成していたので、行列演算ライブラリ(Eigen)を組み込む事は簡単だったが、ロボットアームの管理情報を階層化したのでプログラムが再帰構造になり、コンパクトにまとまりはしたが、第三者には解りづらいものになってしまった

しかし、DesignSpark mechanicalでデザインを行い、このプログラムで動作確認を行い、アニメーション形式でのプレゼンテーションでクライアントとのすり合わせを十分取った上で作成する事が出来る環境が整ったことになる

また、このプログラムに簡単な物理法則を組み込めば、デザイン時に警告を出す事も可能になりそうだけど、時間が掛かりそうなので、追々作成する事にして、後は、目的解釈部分を作成すれば完成となる!

もう一息だぁ~!

しかし、物理法則を組み込めば、仮想空間でピタゴラスイッチも可能になりそうって誘惑が筆者を襲ってくるので、この誘惑に負けないように頑張らなければです

[ロボットアームの動作]

youtu.be(操作に慣れていないので、カクカク動いてます)

なお、ブログの内容を参照して実行した結果に責任は負いかねますので、ご了承下さい